A inteligência artificial está sendo adotada em tudo, desde automóveis até chatbots, mas produtos com IA — como todos os produtos — eventualmente falham. E a forma como uma empresa divulga seus sistemas de IA afeta as repercussões que enfrentará quando ocorrer uma falha. Julian De Freitas, professor assistente da Harvard Business School, realizou diversos estudos sobre os perigos de um erro de I.A. sob a perspectiva do marketing.

Ele afirma que, para promover com sucesso seus produtos de IA, os profissionais de marketing precisam primeiro entender as atitudes únicas dos consumidores em relação à IA. Especificamente, eles devem considerar cinco armadilhas relacionadas às percepções dos consumidores:

- As pessoas tendem a culpar a IA em primeiro lugar;

- Quando uma IA falha, as pessoas perdem a confiança em outras;

- As pessoas culpam mais as empresas que exageram as capacidades da IA;

- As pessoas julgam com mais severidade IAs que se comportam como humanos; e

- As pessoas ficam indignadas com preferências programadas.

Este artigo analisa como as empresas devem se preparar para falhas — e o que fazer depois que a IA comete um erro. Ele explora as formas como as empresas promovem suas próprias soluções de IA e se suas estratégias representam riscos. E oferece conselhos práticos a gestores que desejam divulgar seus sistemas de IA protegendo suas marcas e fortalecendo a confiança dos consumidores.

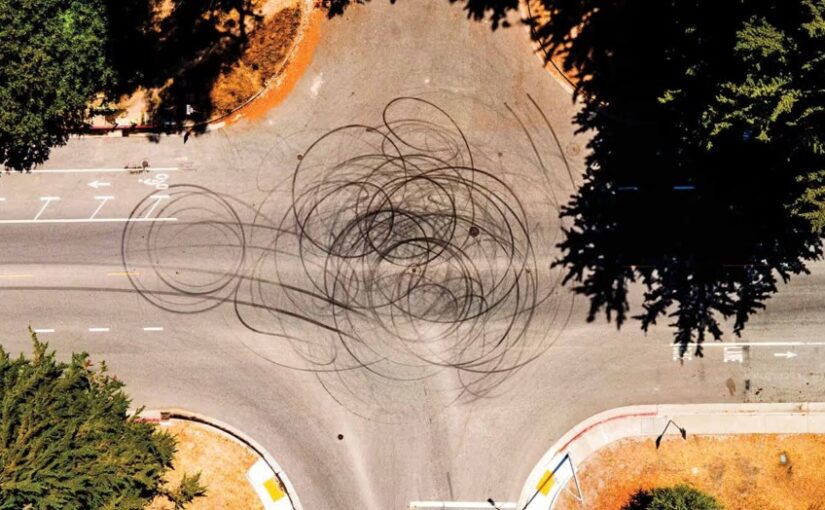

Em outubro de 2023, um veículo automatizado (AV, do inglês Automated Vehicle) operado pela Cruise, subsidiária de robotáxis da General Motors, esteve envolvido em um grave acidente em San Francisco. Um Nissan, dirigido por um ser humano, atropelou uma pedestre, que foi arremessada para a frente do AV. De acordo com a investigação de um consultor de engenharia independente, nenhum motorista humano prudente, nas mesmas circunstâncias, teria conseguido desviar o AV a tempo de evitar a colisão. No entanto, o relatório inicial da Cruise aos reguladores omitiu o fato de que a pedestre foi arrastada por 6 metros sob o AV. Ela sofreu ferimentos graves, mas sobreviveu.

Mesmo não sendo culpada pela colisão, a Cruise enfrentou uma crise após o acidente. Sua falta de transparência resultou em uma multa de 1,5 milhão de dólares aplicada pela Administração Nacional de Segurança no Tráfego Rodoviário (NHTSA). Também foi iniciada uma investigação criminal pelo Departamento de Justiça; a empresa acabou fechando um acordo judicial e pagou uma multa de 500 mil dólares. E não parou por aí. Sua licença para operar em San Francisco foi revogada. Metade da força de trabalho da Cruise perdeu o emprego, o CEO renunciou e a avaliação da empresa caiu mais de 50%. O setor de AVs como um todo também sentiu os impactos. Poucos meses depois, um táxi autônomo da Waymo (pertencente à Alphabet) foi atacado e incendiado por uma multidão em San Francisco, e a NHTSA abriu investigações contra diversos desenvolvedores de AVs, incluindo a própria Waymo e a Zoox (pertencente à Amazon). Ao final de 2024, a GM anunciou que encerraria o desenvolvimento do seu negócio de robotáxis.

A IA está sendo rapidamente adotada em diversos setores, mas o exemplo da Cruise revela uma dura realidade: eventualmente, a IA falha. Quando isso acontece, muitas organizações — sejam desenvolvedoras de seus próprios sistemas de IA ou apenas integradoras de tecnologias alheias — se veem sob intenso escrutínio público. Embora já se tenha escrito bastante sobre como promover a IA para estimular sua adoção, pouco se tem discutido sobre como divulgá-la de maneira que prepare a empresa para as inevitáveis falhas.

Nos últimos sete anos, realizei sete estudos sobre os perigos das falhas de IA sob a perspectiva do marketing. A partir dessa pesquisa, extraí insights sobre como os consumidores percebem e reagem às falhas da IA. Profissionais de marketing bem preparados devem considerar cinco armadilhas relacionadas às atitudes dos consumidores — tanto antes quanto depois de algo dar errado. Neste artigo, vou examinar como as empresas devem se preparar para falhas — e o que fazer depois que a IA falhar. Vou explorar as maneiras como as empresas divulgam suas soluções de IA e se suas estratégias representam riscos. Também vou detalhar como algumas organizações responderam a falhas da IA e oferecer conselhos práticos a gestores que desejam promover seus sistemas de IA protegendo suas marcas e fortalecendo a confiança do consumidor. Vamos analisar cada uma dessas armadilhas a seguir.

As pessoas tendem a culpar a IA em primeiro lugar

Para entender melhor por que a reação pública e regulatória ao incidente da Cruise foi tão severa, meus colegas e eu conduzimos um estudo com mais de 5.000 participantes. Apresentamos a eles um cenário de acidente semelhante ao caso da Cruise — em que um motorista humano colidia com um pedestre, que era lançado na frente de um segundo veículo, que não tinha culpa. Um grupo de participantes foi informado de que o veículo sem culpa era dirigido autonomamente; o outro grupo foi informado de que era conduzido por um humano. Em seguida, pedimos que os participantes avaliassem o quão responsável era o fabricante do veículo.

Os participantes atribuíram maior responsabilidade ao fabricante do veículo sem culpa quando este era conduzido autonomamente do que quando era operado por um humano — mesmo que, em ambos os casos, o veículo não pudesse ter feito nada para evitar o acidente. Eles também consideraram a empresa de veículos autônomos mais responsável do que o motorista humano do mesmo veículo (quando era operado por um humano). Esse resultado foi replicado por um grupo de pesquisa independente na China, demonstrando que o viés persiste em diferentes contextos culturais.

A culpa é mal atribuída nesses casos porque os respondentes, distraídos pela novidade do veículo autônomo, imaginam o que poderia ter acontecido se o AV não estivesse presente. Notavelmente, nessas situações, eles tendem a imaginar o que um motorista perfeito faria, levando-os a exigir da IA um padrão mais alto do que o razoável. Concluem, por exemplo, que o AV poderia ter evitado a colisão desviando antes do impacto, mesmo que isso fosse impossível. Esses cenários hipotéticos influenciam os participantes a verem o AV como mais responsável pelo acidente do que um humano na mesma situação.

Em testes posteriores, descobrimos que redirecionar o foco para o motorista humano culpado (aquele que causou o acidente inicialmente) reduzia o nível de culpa atribuído à IA. Quando a atenção das pessoas era desviada da novidade do AV para outros fatores relevantes, elas eram menos propensas a imaginar cenários irreais. No entanto, desviar a atenção da novidade não deve ser confundido com enganar deliberadamente os envolvidos: executivos não devem esconder detalhes sobre o papel da IA em incidentes de falha. Embora os líderes da Cruise tenham enfatizado a culpa do motorista humano, eles não revelaram o dano adicional causado pelo veículo ao arrastar a pedestre. Quando isso veio à tona, a Cruise perdeu o controle da narrativa na mídia e comprometeu a confiança dos reguladores.

Quando uma IA falha, as pessoas perdem a confiança em outras

Os efeitos em cascata do incidente com a Cruise sobre outras empresas como Waymo e Zoox sugerem outro risco associado à falha de sistemas de IA: quando a IA de uma empresa falha, as pessoas tendem a acreditar que os sistemas de IA de outras empresas também apresentam falhas semelhantes. Esse efeito de contaminação pode prejudicar a percepção pública sobre diferentes formas de inteligência artificial.

Um estudo conduzido pelos professores Chiara Longoni, Luca Cian e Ellie Kyung oferece um excelente exemplo de como ocorre essa contaminação por falha. Eles informaram 3.724 pessoas sobre um problema: o estado do Arkansas não alocou corretamente benefícios por invalidez a uma pessoa com deficiência. Alguns participantes foram informados de que a culpa era de um funcionário humano; outros, de que o erro havia sido cometido por um algoritmo. Em seguida, os pesquisadores perguntaram o quão provável seria que um funcionário ou um algoritmo de outro estado (Kentucky) também cometesse um erro ao alocar os benefícios. Os participantes se mostraram mais propensos a prever que o algoritmo falharia do que o humano de Kentucky. Os pesquisadores replicaram esse efeito em outros tipos de falhas de IA, como a má alocação de pagamentos da Previdência Social.

Os respondentes reagiram dessa maneira porque, segundo os pesquisadores, muitas pessoas não entendem como a IA funciona. Elas tendem a pensar que as soluções de IA fazem parte de um grupo homogêneo e compartilham as mesmas características básicas; não enxergam os sistemas de IA como entidades distintas, com capacidades e falhas próprias.

Para evitar ser contaminado por falhas causadas por outras empresas, é importante destacar como os seus sistemas de IA se diferenciam dos concorrentes. Enfatize aspectos como algoritmos proprietários, medidas de segurança e supervisão humana. Considere como a empresa de IA Anthropic desenvolveu e divulga o Claude, seu modelo de IA generativa. Ela o descreve como “um assistente de IA de próxima geração… treinado para ser seguro, preciso e confiável, ajudando você a dar o seu melhor.” A Anthropic afirma que treina o Claude com uma abordagem “constitucional”, mais transparente, interpretável e alinhada com valores humanos. Isso ajuda a dissociar o Claude de modelos concorrentes populares como o ChatGPT e o Bard, que são treinados de maneira diferente e já foram acusados de gerar informações imprecisas ou enviesadas. Se algum desses concorrentes falhar, a Anthropic já terá construído a base para limitar os efeitos de contaminação por falha.

Outra medida preventiva é comunicar de forma clara quando há supervisão humana sobre a IA, com decisões finais sendo tomadas por pessoas. Quando ocorre uma falha nesse tipo de arranjo com “humano na tomada de decisão”, as pessoas tendem a presumir menos que outras IAs também são falhas, possivelmente porque não enxergam esse tipo de falha como uma condenação generalizada à inteligência artificial.

As pessoas colocam mais culpa nas empresas que exageram as capacidades da IA

A Tesla se refere ao seu sistema de assistência ao motorista como Autopilot, mesmo que sua operação exija supervisão ativa do condutor na estrada. Após vários acidentes fatais envolvendo Teslas com o recurso Autopilot ativado, a montadora passou a enfrentar processos judiciais, incluindo uma investigação do Departamento de Justiça sobre se esse rótulo constitui marketing enganoso. A Administração Nacional de Segurança no Tráfego Rodoviário (NHTSA) também solicitou que a Tesla ajustasse suas comunicações públicas para refletirem com mais precisão as capacidades e limitações do sistema.

O CEO da Tesla, Elon Musk, historicamente defendeu o uso do termo Autopilot alegando que ele foi emprestado da aviação, onde é utilizado como um auxílio ao piloto e não como um sistema totalmente autônomo. Mas será que os consumidores interpretam dessa forma?

Meus colegas e eu investigamos essa questão de má representação em um estudo com 9.492 participantes, utilizando simulações de direção e cenários hipotéticos de acidentes. Informamos a um grupo que uma montadora planejava lançar um novo veículo automatizado com o nome Autopilot (sugerindo alta capacidade de IA); o outro grupo foi informado de que o nome seria Copilot (sugerindo uma capacidade intermediária). Os participantes então foram colocados em uma simulação de direção e instruídos a assumir o controle do volante sempre que julgassem necessário. Na simulação, o veículo se aproximava de um cruzamento movimentado e seguiria em direção a pedestres que atravessavam fora da faixa, a menos que o participante interviesse.

Descobrimos que os participantes assumiam o controle do veículo mais tarde quando ele era rotulado como Autopilot do que quando era chamado de Copilot. Isso sugere que o próprio rótulo os deixava complacentes. Quanto mais capazes eles achavam que o veículo era, conforme indicado pelo nome, mais tarde eles intervinham. Em outros estudos, verificamos que as pessoas têm maior tendência a responsabilizar empresas por acidentes quando estas utilizam rótulos que sugerem maior capacidade, indicando que tais rótulos resultam tanto em comportamentos de consumo mais arriscados quanto em mais culpa atribuída quando ocorre uma falha.

Com base nesses resultados, meus colegas e eu levantamos a hipótese de que uma abordagem comum de marketing pode ter efeito contrário quando se trata de falhas de IA: promover o produto como superior aos concorrentes. Nossos estudos subsequentes confirmaram essa hipótese: quando as empresas faziam isso, aumentavam a percepção da capacidade de seus sistemas, o que, inadvertidamente, aumentava a responsabilidade percebida quando ocorriam falhas. Essa constatação sugere que campanhas publicitárias como a da GM, com o slogan “Humanos são péssimos motoristas”, podem ter levado os consumidores a atribuir mais culpa à Cruise por acidentes nos quais ela se envolveu posteriormente.

Esses efeitos ocorrem porque os sistemas de IA podem variar de autonomia parcial (em que o humano é o principal responsável pela operação) até autonomia total (em que a IA está no controle). No entanto, a maioria dos consumidores não sabe onde um determinado sistema se encaixa nesse espectro. Isso cria um dilema para os profissionais de marketing. Embora rótulos honestos reflitam as capacidades reais do sistema, as empresas muitas vezes são tentadas a usar rótulos que exageram suas capacidades para impulsionar as vendas.

Se você usar um rótulo enganoso para divulgar sua IA, deve explicar com precisão e clareza as reais capacidades da tecnologia em outro lugar, como no seu site ou até mesmo nas letras miúdas do produto. Minha pesquisa mostra que empresas que divulgam as verdadeiras capacidades da IA juntamente com rótulos exagerados enfrentam menos penalidades quando a IA falha, em comparação com empresas que usam apenas os rótulos enganosos. A outra opção, naturalmente, é simplesmente usar desde o início um rótulo menos enganoso. Embora essa abordagem tenha o inconveniente óbvio de não ampliar a percepção das capacidades da sua IA, pelo menos é isenta de riscos.

As pessoas julgam com mais rigor as IAs humanizadas

As empresas estão adotando cada vez mais sistemas de IA que apresentam características humanas.

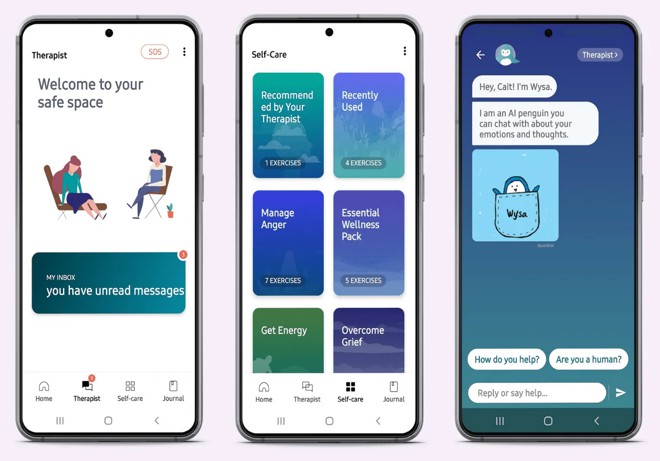

O aplicativo de saúde mental Wysa, por exemplo, usa um avatar em estilo cartoon que ajuda os usuários a completar exercícios, enquanto aplicativos de companheirismo por IA, como o Replika, utilizam imagens humanas realistas que expressam “sentimentos” e “reflexões”.

Esses elementos podem criar a impressão de que o bot possui sentimentos pessoais, objetivos, desejos e outras qualidades que na verdade ele não tem. Bots humanizados oferecem vários benefícios às empresas em comparação com bots neutros: aumentam a intenção de compra dos consumidores, o nível de confiança, a lealdade à marca, a conformidade com solicitações do provedor e a disposição para divulgar informações pessoais. Esses efeitos persistem mesmo quando as pessoas sabem que estão interagindo com uma máquina.

Em um estudo conduzido pelas professoras Raji Srinivasan e Gülen Sarial-Abi, os participantes foram informados sobre uma empresa de investimentos financeiros que cometeu um erro que resultou em perdas para seus clientes. Um grupo de participantes foi informado de que o erro foi cometido por um “programa algorítmico”; o outro grupo foi informado de que o responsável era uma IA humanizada chamada “Charles”. Constatou-se que as atitudes em relação à marca foram mais negativas quando o algoritmo foi humanizado.

Estudos posteriores sugerem que bots humanizados são mais propensos a receber atribuições de capacidades mentais, como lembrar, entender, planejar e pensar, o que leva os participantes a atribuírem maior responsabilidade aos bots por qualquer falha. Em outro estudo, liderado por Cammy Crolic, foi constatado que os participantes avaliaram um chatbot com falhas de forma mais negativa quando ele usava sinais humanos tanto verbais quanto visuais (linguagem em primeira pessoa, apresentação como “Jamie” e avatar feminino) do que quando usava apenas sinais verbais humanizados. Isso sugere que traços humanizados têm um efeito cumulativo nas reações negativas a falhas.

É importante ter cautela especial ao usar chatbots em áreas onde os clientes podem estar irritados. Em outro estudo liderado por Crolic, os pesquisadores analisaram aproximadamente 500 mil sessões de chatbot em uma empresa internacional de telecomunicações. Eles descobriram que, quanto mais os clientes tratavam os bots como humanos (usando, por exemplo, o primeiro nome do bot nas conversas), maior era a insatisfação quando os clientes estavam com raiva. Uma forma de mitigar esse efeito é usar bots humanizados seletivamente em áreas neutras — como pesquisas de produtos — e com menos frequência em funções que geralmente envolvem clientes irritados, como centrais de atendimento ao consumidor. Outra estratégia é moderar as expectativas assim que o cliente iniciar uma conversa com o chatbot.

O bot do Slack, por exemplo, diz: “Olá, sou o Slackbot. Tento ser útil. (Mas ainda sou só um bot. Desculpe!)”. Bots que fazem esse tipo de revelação têm menos chances de enfurecer os clientes quando falham.

As pessoas ficam indignadas com preferências programadas

Em 2016, um gerente sênior da Mercedes-Benz declarou que, ao desenvolver seus veículos autônomos, a empresa priorizaria a segurança dos passageiros em detrimento dos pedestres e outros usuários da via. A lógica era simples: se apenas uma vida pudesse ser salva, deveria ser a de quem estava dentro do carro. A declaração gerou uma tempestade na mídia. Uma manchete de tablóide chegou a acusar a montadora de basicamente optar por “atropelar uma criança em vez de desviar” para proteger os ocupantes do veículo. Poucas semanas depois, a Mercedes-Benz veio a público esclarecer que nem os engenheiros nem os sistemas autônomos deveriam fazer julgamentos sobre o valor relativo das vidas humanas. As reações emocionais a esse episódio sugerem que as pessoas consideram antiético que empresas programem preferências com base em grupos (como idade, gênero ou status de cliente) em sistemas de IA.

Para testar essa hipótese, realizei um estudo com a professora Mina Cikara, de Harvard, no qual pedimos a 826 participantes nos Estados Unidos que imaginassem que um veículo totalmente automatizado enfrentava diversos dilemas difíceis — como decidir entre desviar em direção a um idoso ou a uma criança — e acabava colidindo com uma pessoa de um desses dois grupos. O mais importante é que variamos se a decisão do veículo era aleatória ou baseada em uma preferência programada para favorecer um dos grupos.

Descobrimos que os participantes ficaram mais indignados quando o veículo tomou a decisão com base em uma preferência programada do que quando escolheu aleatoriamente. Isso sugere que as empresas talvez não devam comunicar que seus sistemas tomam decisões baseadas em preferências entre grupos. Em alguns casos, pode ser até aconselhável evitar coletar dados como raça, gênero e idade para alimentar o comportamento dos sistemas de IA. Outra abordagem é usar características estruturais da situação, como priorizar salvar mais pessoas em vez de menos.

Um estudo de Yochanan Bigman e Kurt Gray constatou que as pessoas são mais favoráveis a sistemas de IA que utilizam preferências estruturais do que aquelas baseadas em grupos, possivelmente porque existe uma razão utilitarista clara nas preferências estruturais com a qual a maioria concorda.

Falhas de IA são inevitáveis. Os profissionais de marketing precisam reconhecer que as mesmas ações que aumentam a adoção hoje podem gerar problemas quando ocorre uma falha, especialmente quando essas ações destacam os benefícios e a superioridade da IA. Portanto, antes de implementar uma estratégia de marketing, certifique-se de entender os cinco riscos relacionados à IA. Avaliar esses riscos pode ajudar sua empresa a adotar uma estratégia de marketing que venda sua IA no presente, reduzindo ao mesmo tempo a responsabilidade e o risco para a marca em eventuais falhas futuras.

Fonte:

Uma versão deste artigo foi publicada na edição de julho–agosto de 2025 da Harvard Business Review. Traduzido pelo ChatGPT 4.

Sobre o autor:

Julian de Freitas é professor assistente na área de marketing da Harvard Business School.